Những thách thức chơi golf mạng thần kinh trước đây ( này và cái kia ) đã thôi thúc tôi đặt ra một thử thách mới:

Các thách thức

Tìm mạng nơ ron dẫn nguồn nhỏ nhất sao cho, với bất kỳ vectơ đầu vào 4 chiều nào với các mục nguyên trong , mạng đầu ra với một lỗi phối hợp-khôn ngoan nhỏ hơn .

Quyền tiếp nhận

Đối với thách thức này, một mạng lưới thần kinh feedforward được định nghĩa là một thành phần của các lớp . Một lớp là một hàm được chỉ định bởi một ma trận của trọng lượng , một vector của những thành kiến , và một chức năng kích hoạt được áp dụng coordinate- khôn ngoan:

Vì các chức năng kích hoạt có thể được điều chỉnh cho bất kỳ tác vụ nhất định, chúng tôi cần hạn chế lớp chức năng kích hoạt để giữ cho thử thách này thú vị. Các chức năng kích hoạt sau đây được cho phép:

Danh tính.

ReLU.

Softplus.

Hyperbolic tiếp tuyến.

Sigmoid.

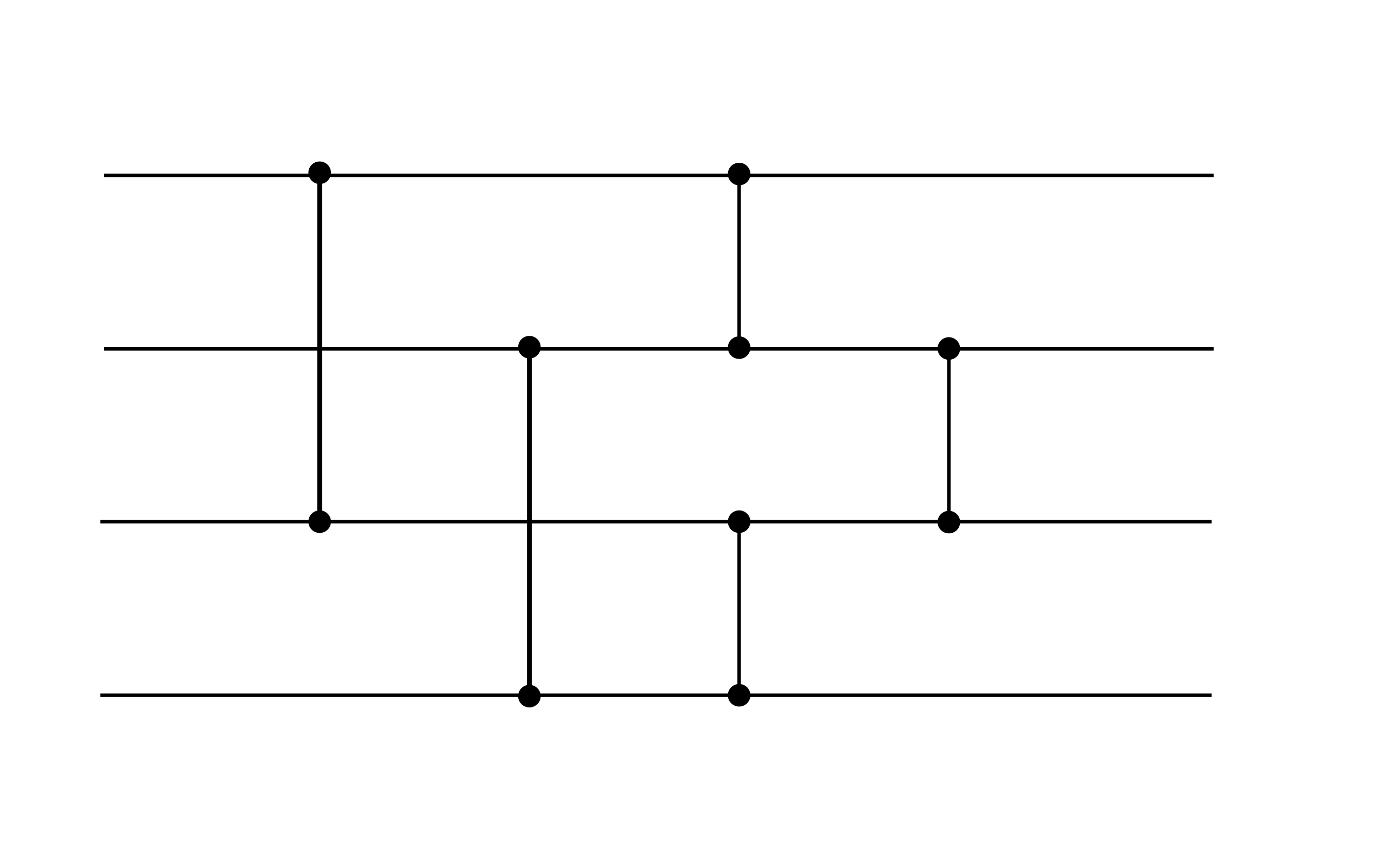

Nhìn chung, một lưới thần kinh có thể chấp nhận có dạng đối với một số , trong đó mỗi lớp được xác định bởi trọng lượng , những thành kiến , và một chức năng kích hoạt từ danh sách trên. Ví dụ: mạng lưới thần kinh sau đây được chấp nhận (trong khi nó không thỏa mãn mục tiêu hiệu suất của thử thách này, nó có thể là một tiện ích hữu ích):

Ví dụ này thể hiện hai lớp. Cả hai lớp có độ lệch bằng không. Lớp đầu tiên sử dụng kích hoạt ReLU, trong khi lớp thứ hai sử dụng kích hoạt nhận dạng.

Chấm điểm

Điểm của bạn là tổng số khác trọng số và độ lệch nhau.

(Ví dụ: ví dụ trên có điểm 16 vì các vectơ sai lệch bằng không.)